Cluster

Ein Verbundrechnersystem oder Cluster bezeichnet eine Anzahl von Einzelrechnern, die zu einem logischen Verbund gekoppelt sind. Ein Cluster wird in der Regel als ein zusammenhängendes Gerät betrachtet.

Warnung

Die Grundeinstellungen des Clusters sind werksseitig vorkonfiguriert und sollten nur durch den Kundendienst der m-privacy GmbH geändert werden. Unsachgemäße Änderungen gefährden den Betrieb des gesamten Clusters.

Die Konfiguration der Clustereinstellungen erfordert eine Anmeldung als Administrator config an der Konsole. Das Untermenü Cluster befindet sich im Hauptmenü.

Um den Clustermodus zu aktivieren muss der Menüpunkt Aktiviere TightGate-Cluster = Ja im Clustermenü ausgewählt werden. Erst danach öffnet sich das Konfigurationsmenü.

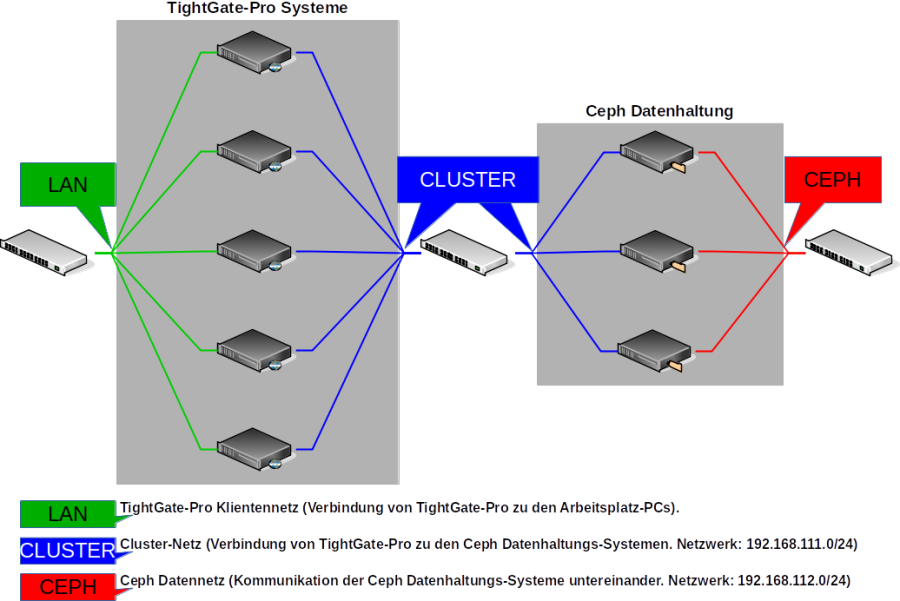

Die nachfolgende Schematische Abbildung verdeutlicht den Aufbau eines TightGate-Pro Clusters mit Ceph-Datenhaltung.

Folgende Konfigurationseinstellungen sind unabhängig von der der Art der zentralen Datenhaltung zu setzen:

| Menüpunkt | Beschreibung | |

|---|---|---|

| Cluster-Basis-Name* | Im Cluster verwendeter Rechnername ohne die angehängte laufende Nummer. Aus diesem Namen werden die verwendeten Rechnernamen im Cluster generiert. | |

| Cluster-Partner-IP-Netzwerk* | Cluster-Netzwerk, über das die einzelnen TightGate-Pro (Nodes) mit der Datenhaltung innerhalb des Verbunds kommunizieren. Die IPv4-Adressen der Nodes im Clusternetzwerk müssen immer aufeinander folgende IPv4-Adressen erhalten. Diese sind unabhängig vom Klienten-Netzwerk. | |

| Max. Anzahl Knoten im Update(*) | Legt fest, wie viele Knoten im Cluster gleichzeitig Updates durchführen dürfen. | Bitte in Absprache mit dem technischen Kundendienst der m-privacy GmbH setzen. |

| Anzahl Teil-Cluster* | Anzahl der Teil-Cluster, die in diesem Verbund arbeiten sollen. Haben sie nur einen zentralen Standort an dem alle Nutzer arbeiten, so ist hier eine 1 anzugeben. Haben Sie einen zentralen Standort sowie weitere Nebenstandorte, die jeweils eigene TightGate-Pro Server haben, so ist die Anzahl für jeden Standort hochzuzählen. Es sind maximal 9 Teil-Cluster erlaubt. | |

| Loadbalancer auf diesem Knoten | Auswahl, ob dieser Knoten als Loadbalancer für einen oder mehrere Teil-Cluster arbeiten soll. Es ist darauf zu achten, dass pro Teil-Cluster nicht mehr als 3 Loadbalancer arbeiten sollten. |

Im nächsten Schritt muss festgelegt werden, wie die Datenhaltung bei TightGate-Pro realisiert wurde. Folgende Möglichkeiten bietet TightGate-Pro:

- Externe Ceph-Datenhaltung

- Lokal virtualisierte Ceph-Datenhaltung

Externe Ceph-Datenhaltung

Sofern ein externes Ceph die Daten für den TightGate-Pro Cluster vorhält, sind folgende Konfigurationen vorzunehmen:

| Menüpunkt | Einstellung | Beschreibung |

|---|---|---|

| Verteilte Ceph-Datenhaltung* | Ja | Aktiviert das Untermenü für die Datenhaltung per Ceph. |

| Ceph-Monitor-IPs* | 192.168.111.101 192.168.111.102 192.168.111.103 | Alle IPv4-Adressen der externen Ceph-Monitore. Das Ceph-Netz ist in der Standardkonfiguration durch die m-privacy das Netzwerk 192.168.111.101 ff. In einem Cluster mit 5 Ceph Nodes sind die Monitor-IPs noch um die Adressen 192.168.111.104 und 192.168.111.105 zu ergänzen. |

| Ceph-Benutzer* | tgpro | Der Benutzer, welche auf der Ceph-Datenhaltung Zugriffsrechte für das Home-Verzeichnis und das Backup-Verzeichnis hat. |

| Ceph-Passwort* | Das Passwort für den "tgpro"-Benutzer. | |

| Ceph-Passwort abholen* | Über diesem Menüpunkt kann das für die Clusteranbindung benötigte Ceph-Passwort automatisch vom Ceph-Server abgeholt und gesetzt werden. Dafür Notwendig ist, dass mindestens ein Ceph-Monitor im Menüpunkt Ceph-Monitor-IPs eingetragen ist und dass das root-Passwort des Ceph-Servers bekannt ist. | |

| Ceph-homeuser-Unterpfad* | homeuser | Pfad zu dem HOME-Verzeichnis in der Ceph-Datenhaltung. |

| Ceph-backup-Unterpfad* | backup | Pfad zu dem BACKUP-Verzeichnis in der Ceph-Datenhaltung. |

| —– | ||

| Gemeinsamer Update-Cache* | Ja | Aktiviert einen gemeinsamen Update-Cache auf der Ceph-Datenhaltung. So können alle TightGate-Pro (Nodes) direkt von dort Updates durchführen und müssen Updates nicht individuell herunterladen. |

| Teil-Cluster: XXX* | Das Untermenü wird im nächsten Abschnitt ausführlich dargestellt. | |

| —– | ||

| KVM mit Ceph starten | Nein | Hierdurch (Ja) wird die virtuelle Maschine für das virtuelle Ceph aktiviert und das zugehörige Menü wird eingeblendet (s. u.). |

Virtualisierte Ceph-Datenhaltung

Sofern eine integrierte virtuelle Ceph-Datenhaltung im Einsatz ist, sind folgende Konfigurationen vorzunehmen:

| Menüpunkt | Einstellung | Beschreibung |

|---|---|---|

| Verteilte Ceph-Datenhaltung* | Nein | Deaktiviert das Untermenü für die Datenhaltung per externem Ceph. |

| KVM mit Ceph starten | Ja | Aktiviert die virtuelle Datenhaltung per Ceph und öffnet das weitere Untermenü. |

| KVM-Netzwerk-Bridge | brX | Name der Netzwerkbrücke, welche verwendet wird, um die kvm durchzuleiten |

| KVM-Netzwerk-MAC-Adresse | 52:54:01:XXX | MAC-Adresse des KVM-Netzwerks. ACHTUNG: Müssen sich auf jeden Node unterscheiden. |

| KVM-Partition | /dev/xxx | Partition, auf der die ceph-KVM-Partition installiert ist (default /dev/sda7). |

| KVM Anzahl CPUs | 1-9 | Anzahl der CPUs, welche für die ceph-kvm zur Verfügung stehen. |

| KVM-Speichergröße in GB | 12 | Größe des Hauptspeichers, welcher für die ceph-kvm zur Verfügung steht. |

| KVM-Ceph-Hostname oder IP ändern | Über diesem Menüpunkt können der Name und/oder die IP-Adresse des ersten Netzwerk-Interfaces des Cpeh-KVM angepasst werden. |

Konfiguration eines TightGate-Pro Teil-Clusters

| Menüpunkt | Einstellung | Beschreibung |

|---|---|---|

| Teil-Cluster-Name * | Frei wählbarer Name für den Teil-Cluster | |

| Hostnamen-Basis-Nummer* | 1 | Nummer des ersten Nodes im Teil-Cluster. Die Nummer wird wird den ersten Node im Teil-Cluster angehangen und dann hochgezählt. Im Standard wird bei 1 begonnen. |

| Basis-IP* | 192.168.111.x | Basis-IP des Teil-Cluster-Netzwerks. Die IP sollte den Standard nicht verlassen und sich nur im Hostanteil des Netzwerks 192.168.111.0 unterscheiden. Pro Teil-Cluster gibt es eine Basis-IP bei der begonnen wird und dann für die Anzahl der Nodes hochgezählt wird. Es ist darauf zu achten, dass genügend IP-Adressen für die Anzahl der Nodes im Teil-Cluster vorhanden sind. Wichtig: Es ist unbedingt notwendig, dass alle Nodes im Teil-Cluster fortlaufenden IP-Adresse haben. |

| Anzahl Nodes* | Anzahl der Nodes im Teil-Cluster. | |

| Klienten-DNS-Domäne* | DNS-Domänen-Name dieses Teil-Clusters im Loadbalancer. Das gilt nur für die Namensauflösung der TightGate-Viewer. | |

| Klienten-Basis-IP* | 10.10.10.x | Klienten-IP-Adresse des ersten TightGate-Pro im Teil-Cluster. Wichtig: Es ist unbedingt notwendig, dass alle Nodes im Teil-Cluster fortlaufenden IP-Adresse haben. |

| Klienten-Basis-NAT-/Alias-IP* | Erste IP-Adresse, die TightGate-Pro zurück geben soll, wenn er über seinen Cluster-Namen angesprochen wird. Die Adressen werden fortlaufend von TightGate-Pro hochgezählt. Es müssen so viele IP-Adressen zur Verfügung stehen, wir der Cluster Nodes hat. | |

| Weitere DNS-Einträge* | Eintragung weiterer beliebiger DNS-Einträge für den Teil-Cluster. Für jeden Eintrag wird automatisch eine Rückauflösung mit angelegt. | |

| - - - Folgende Menüpunkte betreffen verteilte Cluster mit zentraler Datenhaltung. - - - | ||

| Sytem-Domäne* | Verschiedene Standorte können verschiedene Domänen haben (niederlassung-a.firma.local, nierderlassung-b.firma.local etc.). Nur wenn abweichend von config → Gruneinstellungen → Domäne. | |

| SSL-Server-CN* | DNS-Name (FQDN) des TightGate-Pro-Systems , wenn abweichend von config → Gruneinstellungen → DNS-Name im Zertifikat (tgp.niederlassung-a.firma.local) | |

| Uplink-DNS-Server* | Verschiedene Standorte können verschiedene Nameserver nutzen. Notwending wenn abweichend von config → Netzwerk → Nameserver. | |

| Lokaler Domänen-Nameserver* | Meist zur Auflösung der AD-Domäne benötigt. Nur benötigt, wenn abweichend von config → Netzwerk → Lokale Domänen-Nameserver. | |

| Uplink-NTP-Server* | Verschiedene Standorte können verschiedene Zeitserver nutzen. Notwending wenn abweichend von config → Netzwerk → Zeitserver. | |

| Max. Anzahl DNS-Einträge* | Maximale Anzahl DNS-Einträge dieses Teil-Clusters im Loadbalancer. | |

Nachdem die Einstellungen vorgenommen wurden, sind diese über den Menüpunkt Speichern zu sichern. Anschließend bewirkt die Menüoption Anwenden die Aktivierung der gespeicherten Einstellungen.